¡Tu carrito actualmente está vacío!

Etiqueta: aprendizaje automático

La singularidad tecnológica

La singularidad

Este artículo está inspirado en el contenido de Situational Awareness AI & Technological Singularity

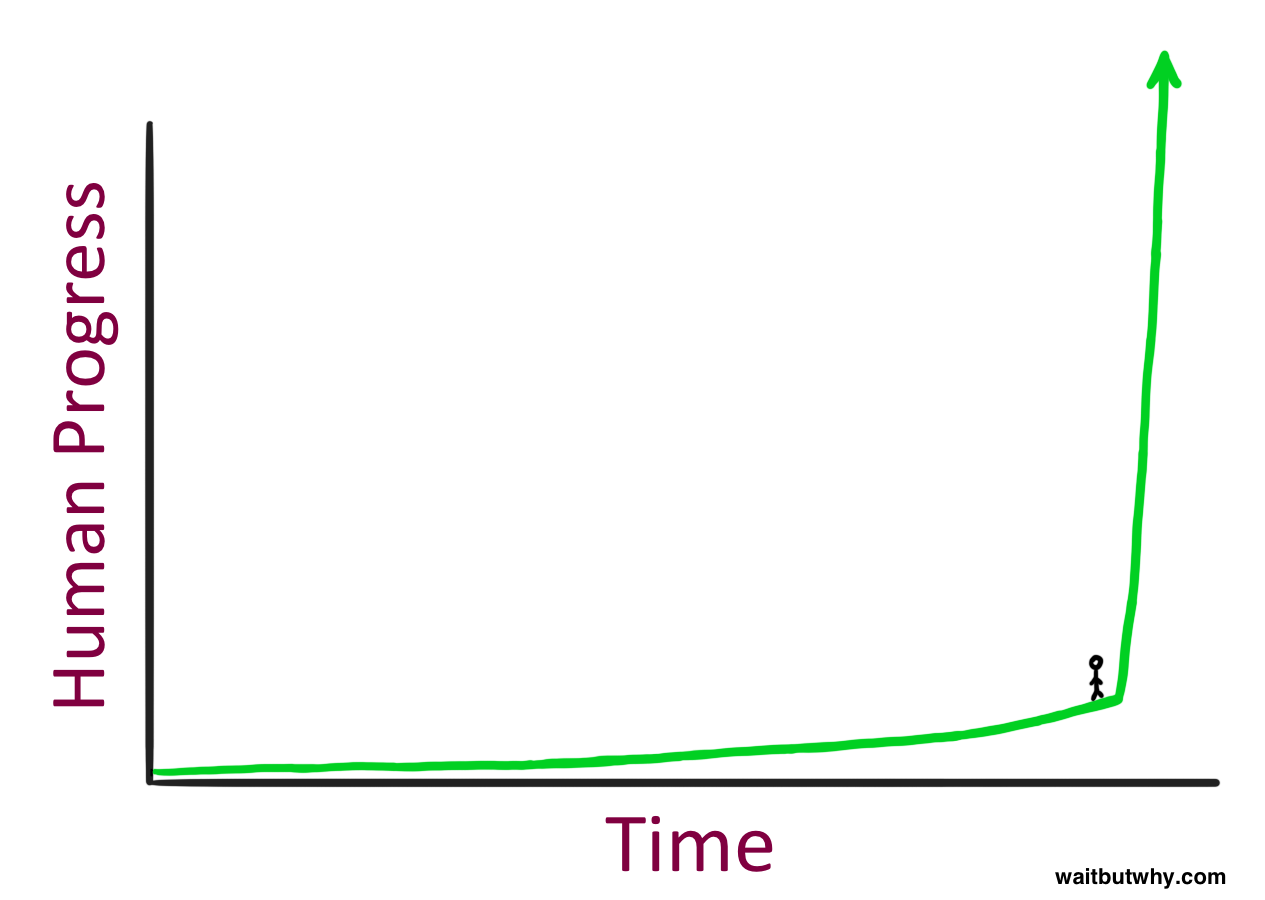

A lo largo de la historia, el progreso de la humanidad ha sido un viaje de descubrimientos matemáticos y científicos básicos que evolucionaron lentamente.

Desde la invención de la rueda y las primeras máquinas simples, pasando por la revolución del vapor y la electricidad en la era industrial, cada avance sentó las bases para el siguiente.

La revolución industrial aceleró el desarrollo con la maquinaria avanzada y la electrificación, transformando sociedades y economías. Sin embargo, fue en el siglo XX, con la invención de los transistores y las computadoras, cuando el progreso tecnológico comenzó a avanzar a una velocidad exponencial.

Hoy, en la era moderna, el ritmo del avance tecnológico se ha acelerado a niveles sin precedentes, y esto parece ser solo el inicio de algo aún más grandioso, algo que sera impulsado en gran medida por la Inteligencia Artificial General (AGI).

En los últimos años, las inversiones en infraestructura de computación, con valores que van de los 10 mil millones a los billones de dólares, han aumentado drásticamente.

Se están asegurando contratos de energía y transformadores eléctricos para alimentar un crecimiento masivo de la producción eléctrica en EE. UU. relacionado con la inteligencia artificial (IA).

La carrera por la IA general (AGI) ha comenzado, y se espera que para finales de la década, las máquinas sean más inteligentes que los humanos. Mientras tanto, pocos comprenden la magnitud de este cambio, pero un pequeño grupo de expertos que predijeron correctamente los avances de la IA en los últimos años está trabajando en esta tecnología, lo que podría llevar a una transformación global o incluso a un conflicto a gran escala.

Otros incluso creemos que la singularidad tecnológica ha comenzado.

¿Que es?

La singularidad tecnológica es un punto hipotético en el tiempo en el que el crecimiento tecnológico se vuelve incontrolable e irreversible, resultando en consecuencias imprevisibles para la civilización humana.

Según el modelo de explosión de inteligencia de I. J. Good de 1965, un agente inteligente actualizable podría eventualmente entrar en un ciclo de retroalimentación positiva de sucesivas mejoras auto-inducidas; que culminaría en una superinteligencia poderosa, muy superior a toda la inteligencia humana.

Una inteligencia artificial que se mejore a sí misma repetidamente, volviéndose cada vez más inteligente a un ritmo acelerado.

Actualmente estamos viendo modelos de IA que continúan mejorando con cada iteración, superando expectativas previas y mostrando habilidades emergentes que antes se creían exclusivas del intelecto humano.

Modelos como GPT-4, Deepseek, Gemini y Claude han demostrado capacidades avanzadas en comprensión de lenguaje, programación, resolución de problemas y generación de contenido creativo, acercándonos cada vez más a la posibilidad de una IA con capacidades autónomas de aprendizaje y mejora.

¿Qué tipo de innovación sería capaz de crear una inteligencia mucho mayor que la del ser humano, una que puede replicarse un indefinido número de veces?

El inicio

Es evidente que cada tecnología, descubrimiento y avance depende de siglos de esfuerzo y del trabajo de innumerables personas que dedicaron sus vidas a resolver problemas en el pasado.

La inteligencia artificial comienza desde 1943 cuando se publica un modelo matemático de las neuronas biológicas, mismo modelo que usan las neuronas artificiales.En 1960-1970 surgen los primeros sistemas para procesar lenguaje y problemas usando inteligencia estrecha. (Limitados por la computación primitiva)

En 1980-1990 hay avances en aprendizaje automático, redes neuronales y algoritmos de retropropagación.

En los 2000 aparece el aprendizaje profundo, redes neuronales convolutional y algoritmos avanzados que permiten la vision por computadora y el procesamiento de lenguaje natural mas avanzado.

Todas estas tecnologías utilizaban Inteligencia artificial estrecha, inteligencia que solo podia aprender y mejorar en un simple aspecto de reglas definidas. Un ejemplo es Deep Blue que venció a Garry Kasparov el campeón mundial en ajedrez en 1997.Sin embargo, esta nueva revolución de la inteligencia artificial comienza con el artículo “All you need is attention,” publicado por investigadores de Google en 2017.

En este trabajo, los investigadores presentaron una nueva arquitectura de redes neuronales llamada Transformer, la cual lograba de manera ingeniosa integrar todo el contexto de la información procesada por las neuronas.

Esta innovación permitió obtener resultados notables en el procesamiento de lenguaje natural y en la traducción de textos.

Ese mecanismo de atención, a primera vista solo parecía mejorar las arquitecturas ya existentes para traducir texto y Google no le tomo la importancia que realmente ameritaba.

No obstante, una organización de investigación dedicada plenamente a experimentar y avanzar la tecnología de IA sin fines de lucro fue quien descubrió el gran potencial del transformer.

Esa organización se llama OpenAI, quienes trabajaban principalmente en utilizar IA que jugara videojuegos para mejorar los algoritmos de aprendizaje.

OpenAI al estar activamente al tanto de los avances en el campo se topa con la investigación de Google y decide ponerla en práctica para procesar texto, notan potencial y deciden darle más poder computacional y datos de alta calidad introduciendo así la idea del pre-entrenamiento masivo seguido del ajuste fino.El resultado es una serie de modelos que deciden llamar GPT (Generative Pre-trained Transformer), estos modelos empezaron a tener propiedades emergentes, como la programación, matemáticas, generar contenido creativo y pueden generalizar sobre muchas cosas, el mismo modelo sirve para diferentes tipos de problemas, el resto es historia.

- GPT-1: (2018)

- Aproximadamente 117 millones de parámetros.

- Podría compararse con un niño pequeño que tiene una comprensión básica del lenguaje y puede realizar tareas simples de procesamiento de texto.

- Completar textos y generar respuestas coherentes.

- GPT-2: (2019)

- Aproximadamente 1,500 millones de parámetros.

- Podría compararse con un estudiante de preescolar que tiene una comprensión más avanzada del lenguaje y puede realizar tareas más complejas de generación y análisis de texto.

- Generar párrafos de texto coherente, traducción automática, respuesta a preguntas y creación de algún contenido creativo.

- GPT-3: (2020)

- Aproximadamente 175,000 millones de parámetros.

- Podría compararse con un estudiante de primaria o un profesional en áreas específicas, mostrando una comprensión profunda del lenguaje y la capacidad de realizar tareas altamente complejas y especializadas.

- Realizar tareas complejas de NLP con poca o ninguna instrucción específica, generación de contenido creativo, programación y asistente virtual.

- GPT-4: (2023)

- Manejar tareas altamente complejas, resolución de problemas matemáticos avanzados, comprensión de múltiples modalidades de datos y aplicación en campos especializados.

- Aproximadamente 1 billón (1,000,000 millones) de parámetros.

- Podría compararse con un estudiante universitario, mostrando un nivel de conocimiento y habilidad avanzada en diversas áreas, incluyendo matemáticas, programación y generación de contenido creativo.

- GPT-5: (???)

- ????

Cabe mencionar que, aunque OpenAI y sus modelos GPT han sido pioneros en el campo de la inteligencia artificial, no son los únicos ni necesariamente los mejores en el mundo. Cada día, diversas organizaciones y empresas están entrenando modelos para desarrollar nuevas aplicaciones y soluciones innovadoras.

Esta misma arquitectura, el Transformer, se utiliza en una variedad de modelos, incluyendo la generación y reconocimiento de imágenes, audio, video y otras aplicaciones. Esto demuestra la versatilidad y el impacto significativo de esta tecnología en múltiples áreas de manera general.

Como podemos ver, el avance ha sido increíble y nos invita a reflexionar sobre qué tipos de modelos y capacidades podríamos tener en el futuro, considerando que en solo 5 años hemos pasado de modelos primitivos a expertos.

Exponencial

Una modelo exponencial se identifica por un crecimiento lento inicial y conforme pasa el tiempo este crecimiento se acelera cada vez más hasta que su curva se vuelve casi vertical y tiende hacia el infinito.

La ley de Moore es una observación empírica formulada por Gordon E. Moore, cofundador de Intel, en 1965. En su forma original, Moore predijo que el número de transistores en un circuito integrado (microchip) se duplicaría aproximadamente cada dos años. Esta observación se ha mantenido sorprendentemente precisa durante varias décadas y ha sido un motor clave en el avance de la tecnología de semiconductores y la computación.

La gráfica de la población humana ha mostrado un crecimiento exponencial a lo largo de la historia. Desde el siglo XIX, la población mundial ha experimentado un crecimiento acelerado debido a factores como avances en la medicina, mejoras en la agricultura y un aumento en la esperanza de vida.

La inteligencia también demuestra un crecimiento exponencial.

A continuación, te muestro una comparativa del avance tecnológico estable vs exponencial en una gráfica interactiva, úsala para comparar los resultados en diferentes etapas.El modelo matemático de I.J. Good (1965) describe este crecimiento como:

\[ I(t) = I_0 \cdot e^{kt} \]

donde:

- \( I(t) \): inteligencia en el tiempo \( t \)

- \( I_0 \): inteligencia inicial

- \( k \): tasa de crecimiento exponencial

Comparación de Crecimiento

Valores Actuales

Crecimiento Exponencial:0Crecimiento Lineal:0Diferencia:0¿Si este tipo de modelo aparece en multiples sistemas porque es alarmante ahora?

¡Porque se trata de inteligencia! El mismo parámetro que nos ha convertido en la especie dominante del planeta, la causa de innovación y avance científico en el mundo.Veamos como estos modelos de IA han crecido entre inteligencia, cómputo y tiempo:

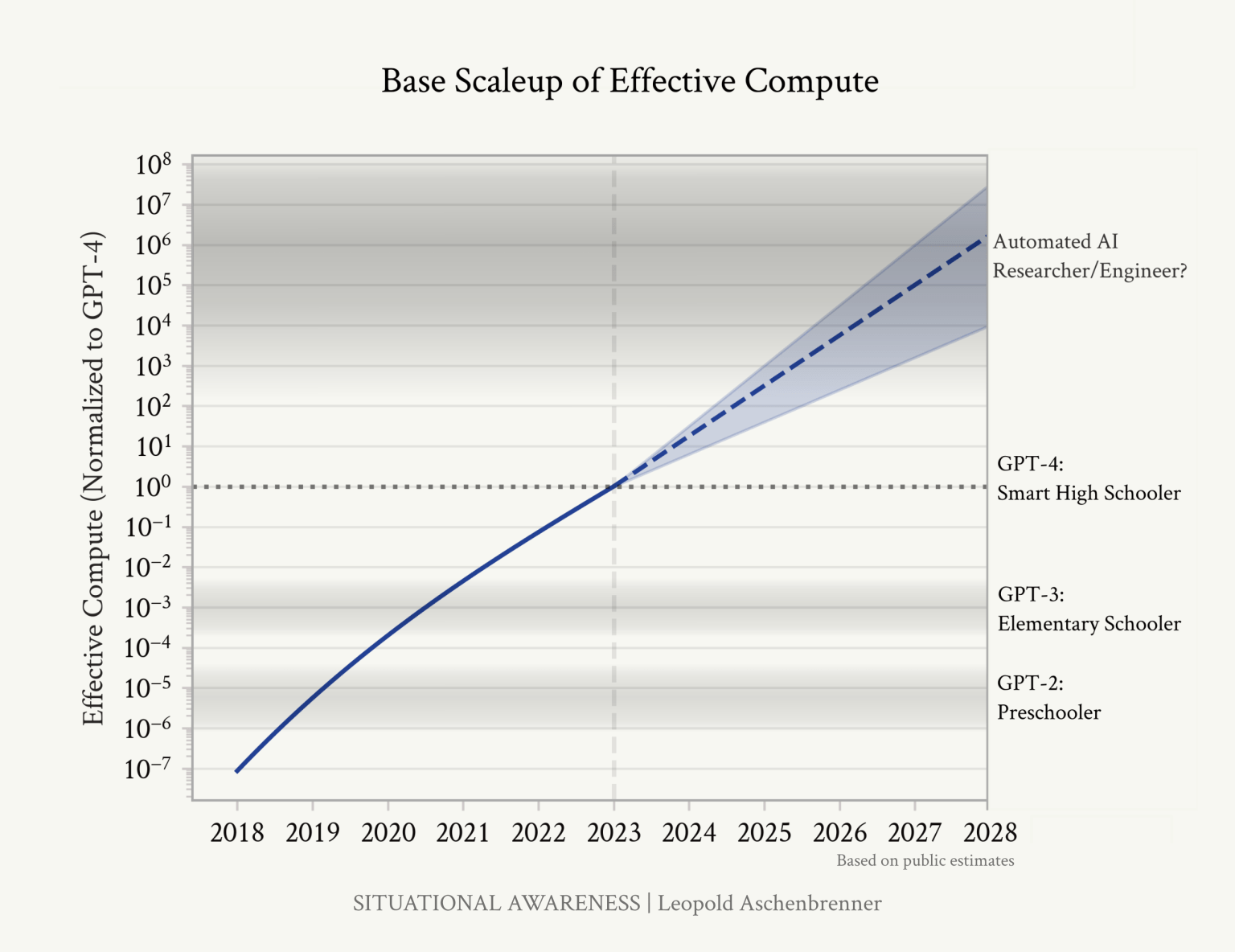

Esta grafica muestra como al escalar en ordenes de magnitud el cómputo obtenemos resultados comparables de GPT-2 a GPT-4 (de prescolar a universitario), ¿que podremos esperar si el avance continua así?

Se espera que para el 2027 se tengan expertos, y si esos modelos son expertos/ingenieros/investigadores en Inteligencia artificial mejores que los propios humanos que los crearon, ¿qué tipo de inteligencias artificiales crearan esos nuevos modelos? Aqui se puede crear un bucle infinito de mejora. Sin mencionar que estos avances no toman en cuenta descubrimientos o mejoras algorítmicas, solo incremento en el poder de cómputo.

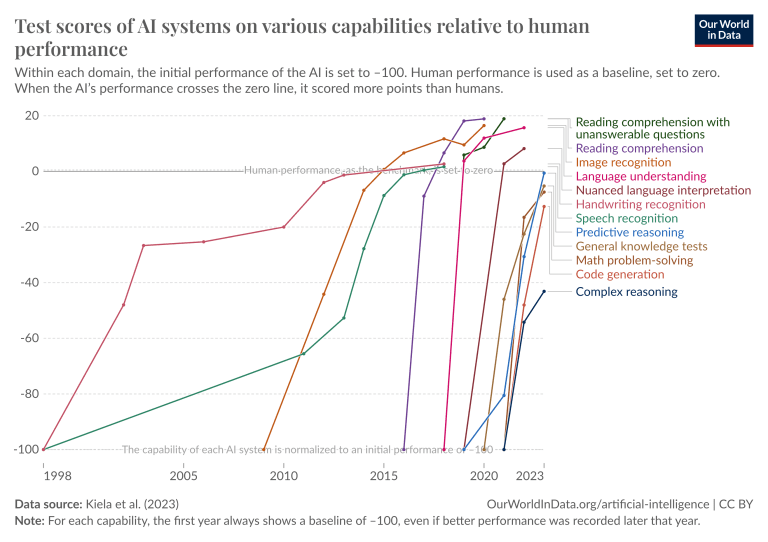

Veamos también una gráfica que muestra el puntaje que están sacando estos modelos comparados con el promedio humano en varios ámbitos

Podemos ver como últimamente muchas de las evaluaciones fueron superadas rápidamente y si… spoiler esa grafica es del 2023, en la actualidad ya se superaron la mayoría de las pruebas, incluso estamos quedándonos sin ideas para evaluaciones que pongan a prueba la IA, algunos ya están seguros de que los modelos modernos han superado a la mayoría de los humanos en inteligencia y que esto es (AGI) Inteligencia Artificial General.

Aqui hay algunas páginas donde los mejores expertos comparan las habilidades de los modelos más recientes:LLM Leaderboard 2025 – Verified AI Rankings

LLM Leaderboard – Compare GPT-4o, Llama 3, Mistral, Gemini & other models | Artificial Analysis

The Big Benchmarks Collection – a open-llm-leaderboard Collection

Y tambien puedes encontrar un análisis super detallado de todo lo mencionado aquí: I. From GPT-4 to AGI: Counting the OOMs – SITUATIONAL AWARENESS

Futuro

Supongamos que estos modelos si son AGI y que el progreso seguirá ¿Entonces que significa todo esto?

Significa que, así como los modelos están sacando mejores calificaciones que los abogados, tendremos los mejores abogados.Dan mejores diagnósticos que los doctores, tendremos miles de los mejores doctores para todos.

Los mejores programadores.

Los mejores docentes.

Mejores escritores

Todo aquello que requiera creatividad e inteligencia sera mejorado y automatizado. Nadie sabe si esto sera bueno o malo.

¿Y si el progreso sigue aún más?

Se cree que estos modelos llegaran a (ASI) Super Inteligencia Artificial

Una inteligencia muy superior a la humana. Es imposible imaginar que repercusiones tuviese esto y los pronósticos son más rápidos que lo esperado.

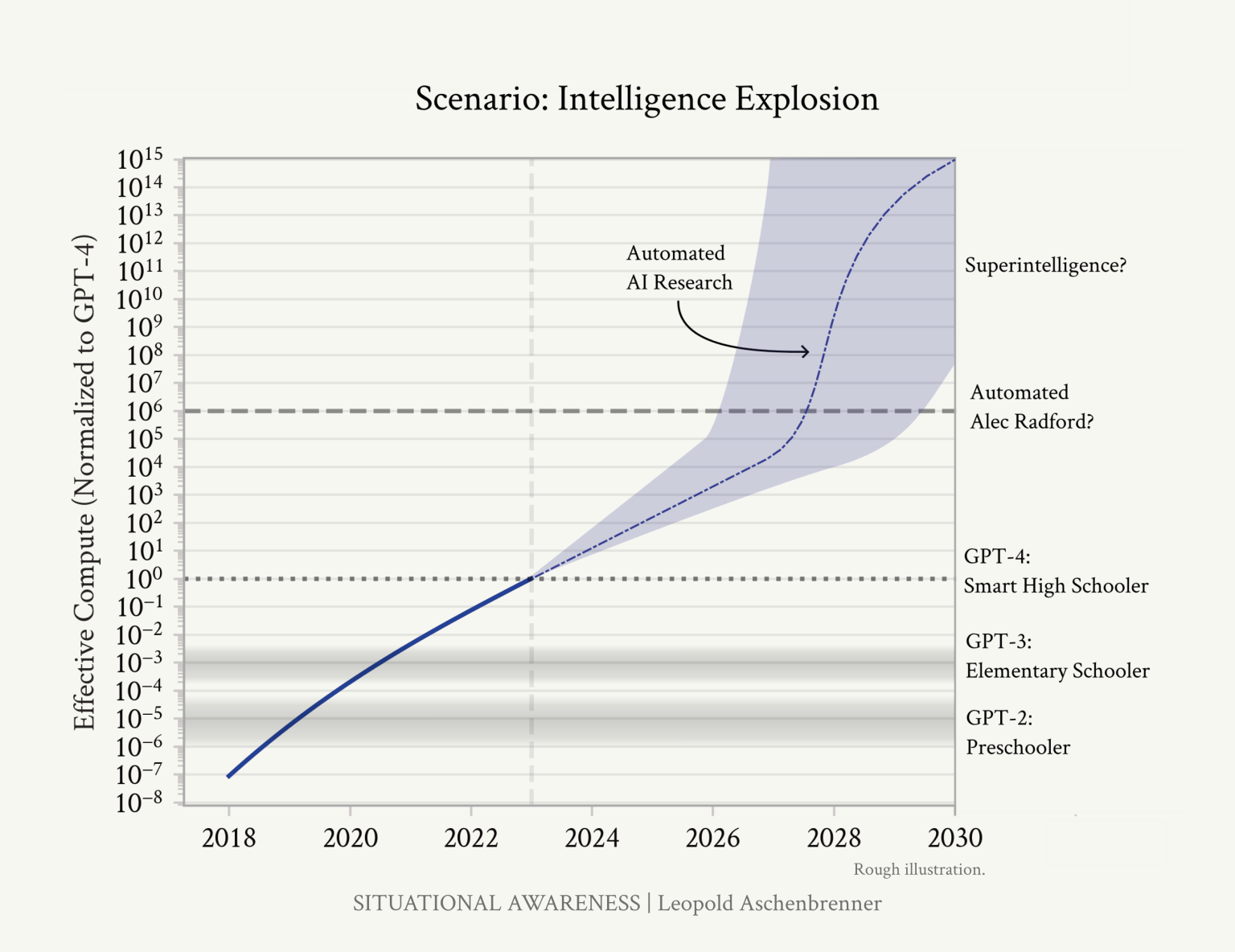

Volvamos a la gráfica anterior, pero expandamos el tiempo un poco y supongamos que la IA llego al nivel humano y paso de ser Inteligencia que razona a inteligencia capaz de innovar y realizar descubrimientos nuevos de manera automatizada.

Las tendencias nos dicen que es posible que esta década aparezca una ASI.

Pero hay varios cuellos de botella plausibles, incluyendo la computación limitada para experimentos, complementariedades con los humanos y el progreso algorítmico volviéndose más difícil, pero ninguno parece suficiente para ralentizar las cosas de manera definitiva.Antes de que nos demos cuenta, tendremos superinteligencia en nuestras manos, sistemas de IA mucho más inteligentes que los humanos, capaces de comportamientos novedosos, creativos y complicados que ni siquiera podríamos comenzar a entender, quizás incluso una pequeña civilización de miles de millones de ellos.

Su poder también sería inmenso. Al aplicar la superinteligencia a la investigación y desarrollo en otros campos, el progreso explosivo se ampliaría desde la investigación en aprendizaje automático; pronto resolverían la robótica, harían saltos dramáticos en otros campos de la ciencia y la tecnología en unos pocos años, y seguiría una explosión industrial.

La superinteligencia probablemente proporcionaría una ventaja militar decisiva y desataría poderes de destrucción inimaginables. Nos enfrentaremos a uno de los momentos más intensos y volátiles de la historia humana.

No necesitamos automatizar todo, solo la investigación en IA. Una objeción común a los impactos transformadores de la ASI es que será difícil para la IA hacer todo. Por ejemplo, algunos dicen que la robótica será un problema complicado, incluso si la IA tiene niveles cognitivos equivalentes a doctorados. O tomar la automatización de la biología, que podría requerir mucho trabajo físico en laboratorios y experimentos con humanos.

Pero no necesitamos la robótica, no necesitamos muchas cosas, para que la IA automatice la investigación en IA. Los trabajos de los investigadores y los ingenieros de IA en los principales laboratorios se pueden realizar completamente de forma virtual y no enfrentan cuellos de botella del mundo real de la misma manera (aunque aún estarán limitados por la capacidad de cómputo). Y el trabajo de un investigador de IA es bastante sencillo, en el gran esquema de las cosas: leer la literatura de ML y desarrollar nuevas preguntas o ideas, implementar experimentos para probar esas ideas, interpretar los resultados y repetir. Todo esto parece estar en el dominio donde extrapolaciones simples de las capacidades actuales de la IA podrían fácilmente llevarnos a los niveles de los mejores humanos o más allá para finales de 2027.

Vale la pena enfatizar lo directas y sencillas que han sido algunas de las mayores innovaciones en aprendizaje automático de la última década: “oh, simplemente agrega algo de normalización” (LayerNorm/BatchNorm) o “haz f(x)+x en lugar de f(x)” (conexiones residuales) o “corrige un error de implementación” (Kaplan → leyes de escalado Chinchilla).

La investigación en IA se puede automatizar. Y automatizar la investigación en IA es todo lo que se necesita para iniciar bucles de retroalimentación extraordinarios.

Podríamos ejecutar millones de copias (y pronto a 10x+ la velocidad humana) de los investigadores de IA automatizados. Incluso para 2027, deberíamos esperar flotas de GPU en los millones. Solo los clusters de entrenamiento deberían estar acercándose a ~3 OOM más grandes, lo que ya nos pone en más de 10 millones de equivalentes A100(NVIDIA).

Eso nos permitiría ejecutar muchos millones de copias de nuestros investigadores de IA automatizados, quizás 100 millones de equivalentes de investigadores humanos, trabajando día y noche. Hay algunas suposiciones que fluyen hacia los números exactos, incluyendo que los humanos “piensan” a 100 tokens/minuto (solo una estimación de orden de magnitud, por ejemplo, considera tu monólogo interno)

También querríamos reservar algunas de las GPUs para ejecutar experimentos y entrenar nuevos modelos.

Además, nuestros investigadores de IA automatizados podrían pronto operar a una velocidad mucho mayor que la humana:

La primera innovación algorítmica en la que trabajen los investigadores de IA automatizados será obtener un aumento de velocidad de 10x o 100x.

Gemini 1.5 Flash es ~10 veces más rápido que el GPT-4 original, apenas un año después, proporcionando un rendimiento similar al GPT-4 original en los benchmarks de razonamiento.

Si esa es la aceleración algorítmica que unos pocos cientos de investigadores humanos pueden encontrar en un año, los investigadores de IA automatizados podrán encontrar victorias similares muy rápidamente. Eso es: espera 100 millones de investigadores automatizados trabajando a 100x velocidad humana poco después de que comencemos a poder automatizar la investigación en IA. Cada uno podrá hacer un año de trabajo en unos pocos días.

Esto podría fácilmente acelerar drásticamente las tendencias existentes de progreso algorítmico, comprimiendo una década de avances en un año.

¿Podrían nuestros millones de investigadores de IA automatizados (pronto trabajando a 10x o 100x velocidad humana) comprimir el progreso algorítmico que los investigadores humanos habrían encontrado en una década en un año en su lugar? Eso sería 5+ ordenes de magnitud en un año.

No solo imagines 100 millones de internos de ingenieros de software junior aquí (los obtendremos antes, en los próximos años).

Los verdaderos investigadores de IA automatizados serán muy inteligentes, y además de su ventaja cuantitativa bruta, tendrán otras enormes ventajas sobre los investigadores humanos:

Podrán leer todos los artículos de ML jamás escritos, haber podido pensar profundamente en cada experimento anterior realizado en el laboratorio, aprender en paralelo de cada una de sus copias y acumular rápidamente el equivalente a milenios de experiencia.

Podrán desarrollar intuiciones mucho más profundas sobre ML que cualquier humano. Podrán escribir fácilmente millones de líneas de código complejo, mantener todo el código en contexto y dedicar décadas humanas (o más) a revisar cada línea de código en busca de errores y optimizaciones. Serán extremadamente competentes en todas las partes del trabajo. No tendrás que capacitar individualmente a cada investigador de IA automatizado (de hecho, capacitar y adaptar a 100 millones de nuevos empleados humanos sería difícil). En su lugar, puedes enseñar y adaptar a uno de ellos, y luego hacer réplicas. (Y no tendrás que preocuparte por la política, la aclimatación cultural y cosas por el estilo, y trabajarán con energía y enfoque máximo día y noche).

Grandes cantidades de investigadores de IA automatizados podrán compartir contexto (quizás incluso accediendo al espacio latente de los demás), permitiendo una colaboración y coordinación mucho más eficiente en comparación con los investigadores humanos. Y, por supuesto, por muy inteligentes que sean nuestros investigadores de IA automatizados iniciales, pronto podremos hacer saltos adicionales en órdenes de magnitud, produciendo modelos aún más inteligentes, aún más capaces en la investigación automatizada de IA.

Imagina un Alec Radford automatizado; imagina 100 millones de Alec Radfords automatizados. Creo que casi todos los investigadores en OpenAI estarían de acuerdo en que si tuvieran 10 Alec Radfords, por no hablar de 100 o 1,000 o 1 millón operando a 10x o 100x velocidad humana, podrían resolver muy rápidamente muchos de sus problemas. Incluso con varios otros cuellos de botella, comprimir una década de progreso algorítmico en un año como resultado parece muy plausible. (Una aceleración de 10x a partir de un millón de veces más esfuerzo de investigación, lo cual parece conservador).

Es sorprendentemente plausible que pasaríamos de IAG a superinteligencia muy rápidamente, tal vez en menos de un año.

II. From AGI to Superintelligence: the Intelligence Explosion – SITUATIONAL AWARENESS

- GPT-1: (2018)